Intelligence artificielle. Big brother ne sera pas européen

Tout en réaffirmant l’importance stratégique de l’intelligence artificielle, la Commission européenne propose au Parlement européen et aux États membres une nouvelle réglementation qui encadre son usage.

« iBorderCtrl », un projet européen d’intelligence artificielle controversé

Nombreux sont les contempteurs du système chinois qui note les citoyens sur internet en fonction de leur comportement dans les lieux publics ou privés, de leurs transactions financières… La sanction d’une mauvaise note serait une interdiction de se déplacer ou aurait des répercussions sur des demandes de prêt, de promotion…

Des mauvaises langues soutiennent que l’Europe n’hésiterait pas à recourir à des systèmes d’intelligence artificielle (IA) tout aussi peu démocratiques que ceux utilisés en Chine.

Elles prennent pour exemple le projet « iBorderCtrl ». Débuté en 2016, il a pour vocation d’accélérer les contrôles aux frontières extérieures de l’Union européenne avec un détecteur de mensonge capable, via un système d’apprentissage automatique, de discerner 38 « micromouvements » attestant ou non de la véracité du discours du voyageur. Selon les détracteurs du projet, il existerait beaucoup de faux positifs et le système ne serait pas fiable. Ce projet est financé sur fonds européens au travers du programme Horizon 2000.

Il est difficile de savoir comment fonctionne le système « iBorderCtrl ». L’agence en charge du projet, interrogée à ce sujet, s’est retranchée derrière le secret des affaires pour ne rien communiquer du dossier, expliquant qu’il ne s’agirait que d’un projet de recherches.

Finalement, un eurodéputé allemand hostile au projet, Patrick Breyer, membre du Parti pirate (mouvement qui défend les libertés numériques et le libre partage des savoirs), a fini par saisir la Cour de justice de l’Union européenne en 2019. En février 2021, cette juridiction avait déjà instruit en grande partie le dossier.

Une IA européenne basée sur l’éthique

L’Union européenne est consciente que l’IA est riche de potentialités fabuleuses, qui ne peuvent qu’améliorer le bien-être de ses citoyens dans des domaines très variés : transport, médecine… Mais, elle craint par-dessus tout que se produisent des dérives inacceptables. Et elle se veut le fer de lance de l’utilisation éthique de l’IA dans le monde : ce n’est sans doute plus sur des barricades que la liberté guide le peuple, c’est désormais avec des ordinateurs ou des données stockées et traitées. Qu’aurait donc peint Delacroix au XXIe siècle ?

Les initiatives tendant à contrôler l’IA se multiplient, ce que l’on ne peut qu’approuver.

Le 6 octobre 2021, le Parlement européen a adopté une résolution sur l’intelligence artificielle en droit pénal et son utilisation par les autorités policières et judiciaires dans les affaires pénales. Il souhaite restreindre de manière drastique ses utilisations.

Quelques semaines auparavant, le 15 septembre 2021, c’était l’ONU qui appelait à un moratoire sur certains systèmes d’IA : les méthodes prédictives, la reconnaissance faciale et la curation ? Cette dernière est une pratique qui permet de fournir, sur un site internet, des contenus sur un sujet donné en ayant auparavant sélectionné puis édité les contenus les plus pertinents du web. Moratoire, le temps qu’une réglementation se mette en place.

Le futur règlement européen sur l’IA

La démarche de l’ONU fait écho à la proposition de règlement européen sur l’IA qui date seulement d’avril 2021.

Ce règlement sera d’application directe en France sans qu’il y ait besoin de loi de transposition. Il faut donc que les entreprises se préparent à son adoption et qu’elles essaient, le cas échéant, d’en influencer le contenu. Pour les entreprises concernées – et il y en aura de nombreuses – les contraintes seront beaucoup plus importantes que celles issues du RGPD.

La Commission européenne a comme souci principal de défendre les droits fondamentaux et de rassurer les citoyens de l’Union sur l’usage de l’IA de telle manière qu’elle se développe.

Aucune date d’adoption de ce règlement n’est encore prévue : en effet, celle-ci résultera du trilogue, c’est-à-dire d’un accord entre la Commission, le Conseil et le Parlement, ce qui est parfois long.

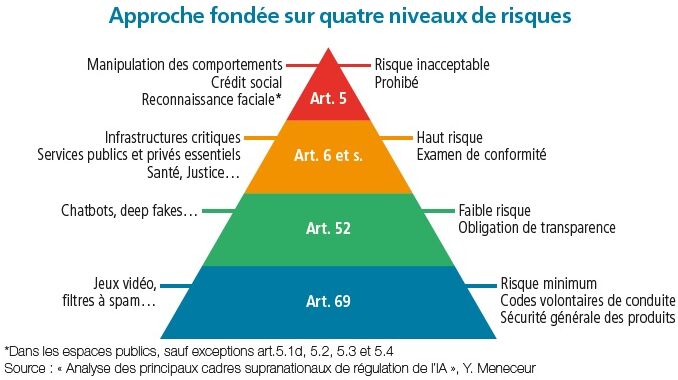

Le futur règlement distingue plusieurs systèmes d’IA :

- ceux qui sont interdits ;

- ceux à haut risque qui sont fortement réglementés ;

- ceux à faibles risques qui comportent des risques de manipulation ;

- ceux à risques minimum.

Le futur règlement interdit la mise sur le marché, la mise en service ou l’utilisation :

- d’un système d’IA qui a recours à des techniques subliminales;

- d’un système d’IA qui exploite les éventuelles vulnérabilités dues à l’âge ou au handicap physique ou mental d’un groupe de personnes donné pour altérer substantiellement le comportement d’un membre de ce groupe d’une manière qui cause ou est susceptible de causer un préjudice physique ou psychologique à cette personne ou à un tiers ;

- d’un système de notation sociale « à la chinoise » exploité par les pouvoirs publics ;

- des systèmes d’identification biométriques à distance en « temps réel » dans des espaces accessibles au public à des fins répressives. Avec cependant des exceptions que déplorent nombre d’associations, mais qui apparaissent nécessaires dans un environnement insécurisé que nous connaissons.

Les systèmes d’IA à haut risque

Le futur règlement définit les systèmes d’IA à haut risque et donne quelques exemples dans son annexe III. Parmi ceux-ci, la gestion et l’exploitation des infrastructures critiques, les systèmes d’IA destinés à être utilisés pour le recrutement ou la sélection de personnes physiques, ou ceux utilisés pour la prise de décisions de promotion et de licenciement dans le cadre de relations professionnelles contractuelles, pour l’attribution des tâches et pour le suivi et l’évaluation des performances et du comportement de personnes dans le cadre de telles relations.

Pour qu’un système d’IA à haut risque puisse être utilisé, certaines exigences doivent être respectées, et notamment :

- organiser et documenter la gestion des risques que pourrait générer le système d’IA ;

- de manière quasi symétrique, les jeux de données d’entraînement, de validation et de test sont assujettis à des pratiques appropriées en matière de gouvernance et de gestion des données;

- une documentation technique relative à un système d’IA à haut risque est établie, avant que ce système ne soit mis sur le marché ou mis en service, et elle est tenue à jour ;

- prévoir l’enregistrement automatique des événements pendant le fonctionnement des systèmes d’IA ;

- le fonctionnement de ces systèmes doit être suffisamment transparent pour permettre aux utilisateurs d’interpréter les résultats du système et de l’utiliser de manière appropriée ;

- prévoir une supervision effective réalisée par des personnes physiques pendant la période d’utilisation du système d’IA ;

- les systèmes d’IA doivent atteindre un niveau approprié d’exactitude, de robustesse et de cybersécurité, et fonctionner de manière cohérente à cet égard tout au long de leur cycle de vie.

Encadrer pour créer les conditions propices au développement de l’IA

Les systèmes d’IA qui présentent un risque minimal sont soumis à des obligations d’information et de transparence.

La proposition de règlement ne prévoit aucune autre restriction ou obligation légale supplémentaire pour les systèmes d’IA ne présentant qu’un risque minimal.

Il sera possible de faire certifier les systèmes d’IA avec un marquage de type CE pour faciliter la commercialisation dans l’Union.

Les obligations des fabricants, commercialisateurs, importateurs et utilisateurs ne sont pas identiques et font l’objet de développements distincts dans la proposition.

Enfin, la proposition de règlement se termine par un véritable droit à l’expérimentation, appelé « bac à sable » dans le texte, et par la création d’un Comité européen de l’intelligence artificielle.

Comme cela arrive souvent, la proposition de règlement européen est un bon compromis entre les besoins d’encadrer l’IA pour éviter des dérives anti démocratiques et le souhait que notre réglementation ne freine pas le développement d’outils indispensables à notre économie et aux sources de progrès.

Elle comporte cependant un manque important : celui de la responsabilité civile du fait des dommages provoqués par l’IA. Cette omission sera peut-être comblée à l’occasion de la révision prochaine de la directive machine ou de celle concernant les produits défectueux.

Article extrait du n° 577 de Face au Risque : « Cybersécurité des systèmes industriels » (novembre 2021).

Thibault du Manoir de Juaye

Avocat à la Cour, spécialiste de la sécurité et de la sûreté dans l’entreprise

Les plus lus…

Toute l’équipe de Face au Risque est ravie d’annoncer qu’elle a remporté la Victoire du design graphique pour son…

Le Conseil national des activités privées de sécurité (Cnaps) a confirmé, le 10 avril 2025, à l’issue d’un recours gracieux,…

Dans un nouveau rapport, Allianz Commercial rappelle que les troubles à l’ordre public constituent le principal risque pour plus…

SHOWA a annoncé le lancement de sa dernière gamme de gants, MFT PRO. Dotés d'une doublure en microfibre récemment mise…

Un peu plus de 2 ans après l’incendie ayant affecté un entrepôt près de Rouen, l’enquête du Bureau d’enquêtes et…

Les particules solides présentes dans les environnements industriels et de fabrication présentent des risques significatifs pour les employés et…